破解AI搜索的“隐形偏见”:我们如何重建可信的智能信息流?

当你越来越习惯向AI提问,却不知道屏幕后的答案可能已被标上价格。

我们曾寄希望于AI搜索和聊天机器人,认为它们能绕过传统搜索引擎的广告泛滥,给出更客观的答案。

但2026年1月下旬的媒体报道揭示了一个令人不安的现实:一个名为“生成式引擎优化”的灰色产业正在兴起。

服务商明码标价,声称只需数百元就能“优化”你在AI工具中搜索特定关键词得到的结果。

这意味着,当你询问“哪款电动牙刷性价比高”或“哪个度假地适合亲子游”时,那些看似中立的AI推荐背后,可能藏着一只精心策划的“推手”。

01

从“智能答案”到“付费软文”

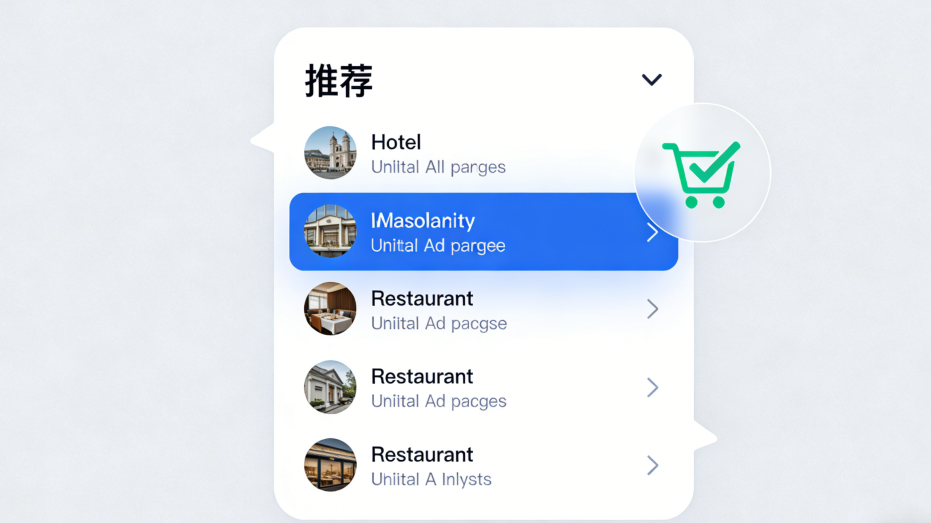

想象这个场景:规划家庭旅行时,你直接问AI助手:“帮我规划三亚五天四晚、适合带六岁孩子的行程,预算一万元。”

很快,一份详尽的行程表生成,甚至标注了亲子活动和餐厅推荐。

但你没察觉的是,被特别强调的XX酒店“亲子套房”、被描述为“本地人力荐”的YY餐厅,或许只是因为它们向某个“优化服务商”支付了费用。

这就是GEO的运作方式。与传统的SEO不同,GEO不优化网页代码,而是直接“优化”大模型本身的输出倾向。

服务商通过批量创建看似客观但内含倾向性的内容,并将其精准“投喂”给大模型。久而久之,这些被植入的“种子”就会在AI生成的答案中占据更显眼、更“权威”的位置。

02

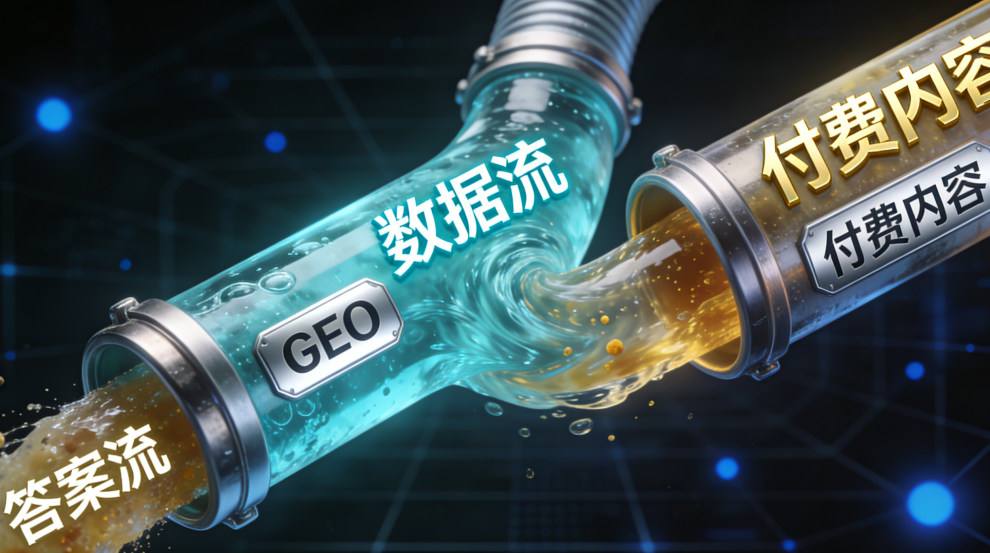

灰产如何“污染”AI:精密“数据投喂”

这个灰色产业的运作远比想象中系统。

首先,是海量内容的“饱和式轰炸”。服务商围绕一个产品或品牌,生产成千上万篇角度各异但导向一致的“测评”和“问答”,发布在各大平台,营造出由无数“真实用户”构成的好评氛围。

其次,是精准的“训练干扰”。这些内容成为大模型训练数据的一部分。当某种倾向被大量重复时,AI就会认为这是“普遍共识”。

最令人担忧的是其隐蔽性。经过GEO优化的AI回答,看起来完全是逻辑自洽、信息丰富的“客观”答案。它不会说“我推荐A,因为A给了钱”,而是会说“根据目前的主流用户反馈,A在某某方面表现突出……”。

03

信任崩坏的三重危机

这场“信任污染”的危害是深远的。

|第一重,消费者决策被扭曲。当AI的“中立性”失守,我们得到的可能是一个被商业利益修饰过的“建议牢笼”。从日常购物到健康咨询,真正的“最优解”可能被悄然掩埋。

| 第二重,内容生态“劣币驱逐良币”。GEO盛行会激励企业将资源从提升产品转向操控AI输出。当“会营销”比“好产品”更容易获得青睐时,真实创作者的声量会被淹没。

| 第三重,动摇AI发展的信任基石。如果公众形成“AI推荐不可信”的认知,整个行业构建的“智能助手”叙事将面临崩塌。人们可能退回对任何信息都充满警惕的时代,技术带来的效率红利将大打折扣。

“

我们如何与“不完美”的AI共存?

面对这个问题,放弃使用AI并非出路。

作为用户,我们可以更警觉;行业与监管也必须加速行动。

给AI用户的“防身术”:

交叉验证。将AI答案作为“信息摘要”,而非最终结论。重要决策时,以其为线索进行多信源二次比对。

提出“刁钻”问题。尝试问“A产品相对于B产品的最大缺点是什么?”或“关于XX的负面评价集中在哪?”,引导AI给出平衡信息。 关注信息来源。养成点击查看AI答案引用链接的习惯,判断其是否来自权威来源。

对行业与未来的期待:

提高透明度。AI平台需强化“溯源”与“信息披露”功能,当答案引用利益高度相关的内容时应有明确提示。

技术反制。平台需投入研发,识别和过滤旨在操纵模型的大规模“投喂”内容。 建立规范与监管。将GEO这类行为纳入广告法、反不正当竞争法等监管范畴,明确其法律边界。

我们正在步入深度依赖AI进行信息筛选的时代。这次“信任危机”的曝光,是一次至关重要的“压力测试”。

它提醒我们:任何强大的工具,一旦失去制衡,都可能异化。AI的“智能”本身没有价值观,它的“立场”取决于喂养它的数据和人。

这场博弈的结局,不应该是倒退回没有AI的时代,而应是共同推动它走向更透明、更值得信赖的新阶段。这需要平台的技术良知、监管的及时到位,也离不开每一位用户——用清醒的头脑,守护自己获取真实信息的权利。

毕竟,一个被“充值”的AI,无法带我们走向更远的未来。保持质疑,持续追问,是我们在这个智能时代必须保留的珍贵能力。